EUs nye AI-regelverk er på vei

AI-forordningen, et felleseuropeisk regelverk for kunstig intelligens, er forventet å tre i kraft i 2024. Forordningen vil ha stor innvirkning på Europa, Norge og ulike bransjer. Formålet er å klassifisere og regulere AI basert på risiko.

Partner Advokatfirmaet Ræder

Advokatfirmaet Ræder

Et krevende og ambisiøst prosjekt

Helt siden forslaget om et felleseuropeisk regelverk knyttet til kunstig intelligens («AI») ble foreslått av Europakommisjonen i april 2021, gjennom forordning 2021/0106(COD) (heretter «AI-forordningen»), har det vært utførlig diskutert og debattert hva regelverket vil bety for Europa og dets utvikling innenfor AI og teknologi. EU er den første regionen som utarbeider et eget AI-lovverk og dette er et krevende og ambisiøst prosjekt. Ikke minst skyldes det at teknologien som skal reguleres, allerede i årevis har utviklet seg raskere enn lovgiverne har kunnet følge med, og behovet for et eget regelverk er allerede på overtid.

I sitt arbeid har EU måttet vekte viktige hensyn mot hverandre, særlig behovet for grunnleggende rettigheter og sikkerhet for menneskene i EU, opp mot det å ikke overregulere og hemme utviklingen av AI-systemer utviklet i Europa, sett opp mot andre land. Sammenliknet med land som allerede var avanserte på AI, hadde europeiske selskaper allerede en lengre vei å gå uten fordyrende og tidskrevende krav fra EU, mente noen.

Det hersker liten tvil om at et regelverk som klassifiserer og regulerer bruken og utvikling av AI, vil innføres. Det er heller ikke tvilsomt at et slikt regelverk er nødvendig for, som EU-kommisjonen selv har uttalt, å ivareta personvern og respekt for grunnleggende rettigheter innad i EU. Med utviklingen av avansert teknologi som nå skjer verden over, spår flere at innføringen av AI-forordningen vil ha like stor innvirkning på bedrifter og enkeltmennesker, som det GDPR hadde i sin tid.

AI forordningen er ikke endelig vedtatt, men vi skal se på AI-forordningens status og antatt betydning for norsk rett, og deretter oppbygningen av og de forskjellige risikoprofilene som AI-forordningen legger opp til.

Oppbygning av regelverket

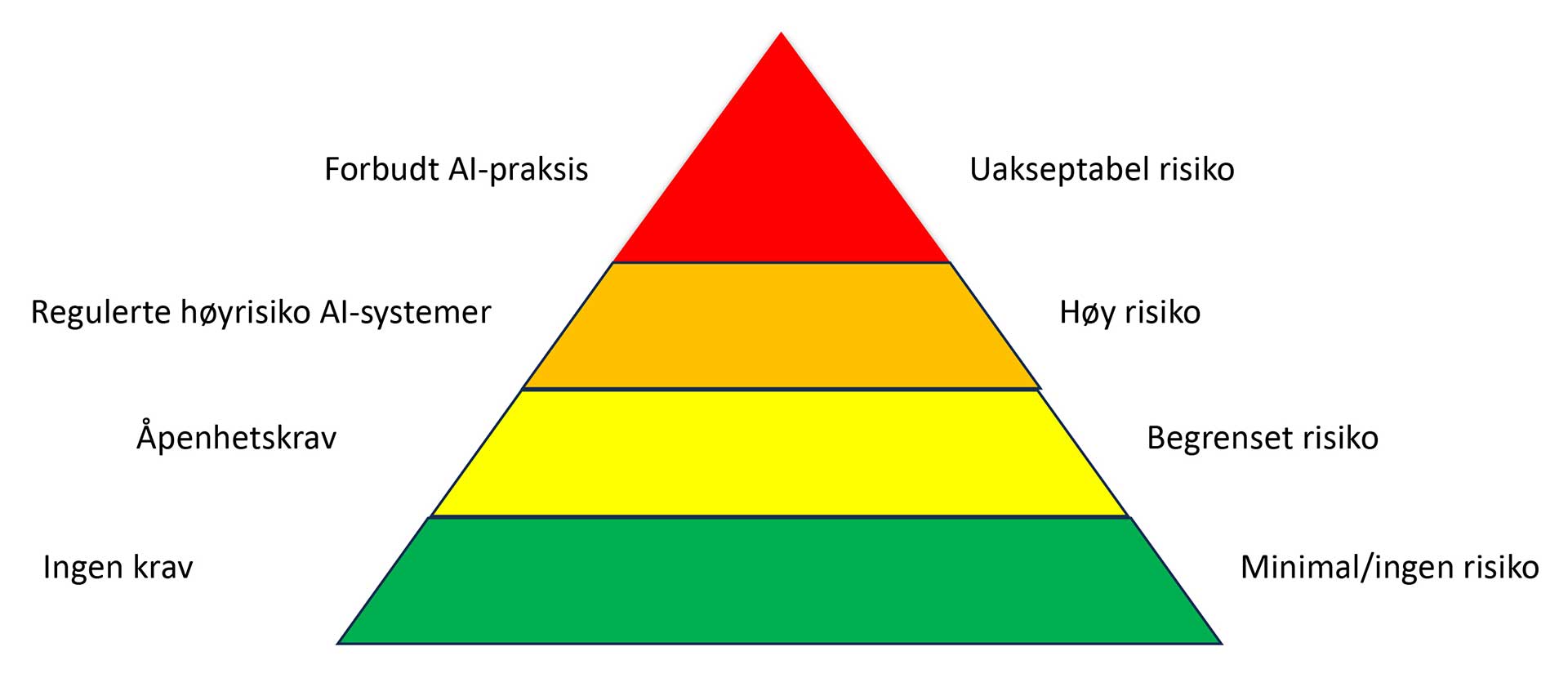

AI-forordningen har tatt utgangspunkt i en risikobasert tilnærming til regulering av AI. Enkelt sagt – desto større risiko den aktuelle AI-aktivitet representerer, desto strengere krav er det til virksomheten som utfører aktiviteten. Forordningen definerer fire risikonivåer, uakseptabel risiko, høy risiko, begrenset risiko og minimal eller ingen risiko, slik som vist i figuren under. Dokumentasjonskrav, vurderingskrav og transparens tilhører de lavere nivåene av risikopyramiden, mens det høyeste risikonivået er forbeholdt aktivitet som er forbudt og som ikke kan utføres.

Uakseptabel risiko

Det høyeste trinnet i risikopyramiden er forbeholdt aktivitet som anses å utgjøre en uakseptabel risiko. Slik aktivitet er forbudt og har etter AI-forordningen den strengeste sanksjonen, med bot på opptil 40 millioner euro og 7 % av selskapets totale omsetning på verdensbasis. Med andre ord kan det bli snakk om svært store beløp for de multinasjonale tek-gigantene. Maksimumboten for overtredelse av forbudt aktivitet ble også oppjustert fra henholdsvis 30 millioner euro og 6 % av verdensomsetningen i den siste versjonen av AI-forordningen som ble godkjent 14. juni i år. Det sier også noe om EUs fokus på at slik overtredelse skal rammes hardt.

Tilsvarende ble det i den sist godkjente versjonen av AI-forordningen en utvidelse av hva slags aktivitet som skal regnes som uakseptabel, ved at flere typer aktiviteter som på en eller annen måte bevisst diskriminerer eller er påtrengende, omfattes. Aktivitet som utgjør uakseptabel risiko, vil etter dette blant omfatte følgende:

Bruk av biometriske identifikasjonssystemer i sanntid i det offentlige rom. Dette vil typisk være bruk av AI for å utføre ansiktsgjenkjenning på mennesker, slik at disse kan identifiseres, eksempelvis i forbindelse med demonstrasjoner eller opptøyer. Det ble diskutert hvordan et slikt forbud ville påvirke Frankrike, som har foreslått en ny lov for bruk av AI for å kunne kontrollere store folkemengder under OL i Paris i 2024. Den foreslåtte loven, som ennå ikke er innført, har imidlertid stadfestet at ingen biometriske data i så fall vil brukes, noe som, avhengig av endelig versjon av AI-forordningen, sannsynlig vil innebære at aktiviteten ikke omfattes av forbudet. Det ovennevnte er imidlertid et godt eksempel på balansen mellom myndighetsutøvelse og ivaretakelse av den enkeltes rettigheter.

Bruk av biometriske identifikasjonssystemer i etterkant av at hendelsene har skjedd. Pr. nå foreslås det at politimyndigheter skal ha en slik anledning ved undersøkelse av alvorlige forbrytelser og kun når nødvendig autorisasjon er gitt av relevant rettsmyndighet.

Systemer som bruker underbevisste teknikker eller er bevisst manipulative eller villedende for å endre en persons eller en gruppes oppførsel, ved å redusere muligheten for den personen eller gruppen til å ta en bevisst og informert beslutning. Selv om definisjonen i dette tilfellet blir vanskelig å enes helt om, er tanken klar: Systemer som kun har til mål å endre menneskers tankesett for å påvirke valg og opptreden, utgjør en uakseptabel risiko. Det mest praktiske eksempelet er såkalt «subliminal advertising», eller underbevisst markedsføring, hvor systemets mål er bevisst å påvirke menneskers opptreden gjennom sosiale medier til å opptre på en spesifikk måte, eksempelvis for å påvirke utfallet av et valg eller for å fremme hat mellom grupper av mennesker.

Systemer som brukes for sosial rangering, hvor mennesker klassifiseres basert på deres sosiale opptreden eller personkarakteristikker.

Systemer som kategoriserer personer basert på sensitive personopplysninger, som kjønn, hudfarge, religion, og politisk tilhørighet, for å nevne noen.

Såkalt «predictive policing», som har til hensikt å forebygge kriminalitet ved å analysere blant annet profilering, lokasjon og tidligere utvist kriminell aktivitet.

Listen ovenfor er ikke uttømmende, og listen av aktiviteter og systemer som inngår i uakseptabel-kategorien, har vært utvidet flere ganger. At de oppstilte aktivitetene er uønskede, hersker det liten tvil om. Ettersom teknologien utvider seg videre, vil det også være behov for å inkludere stadig flere aktiviteter på denne listen.

Høyrisiko

For AI-aktivitet som tilhører høyrisiko-gruppen, vil det gjelde strenge krav til dokumentasjon, transparens og iverksatte sikkerhetsmekanismer for å forhindre at systemene går ut over mennesker. Slike sikkerhetsmekanismer vil blant annet innebære innføring av egne risikosystemer med menneskelig tilsyn ved utforming og implementering av system, dokumentasjonskrav om hvordan systemene fungerer og hvordan AI brukes. Slik dokumentasjon skal kunne gis til relevante myndigheter i kontrolløyemed, og også være tilgjengelig for brukerne av AI-aktiviteten slik at man skal kunne forstå hvordan systemene fungerer.

Også for overtredelse av plikter knyttet til høyrisiko AI-systemer, er det snakk om potensielt store bøter. Hva slags bøter som kan gis, vil avhenge av hvilke plikter som ikke er overholdt, og overtredelse kan gi grunnlag for bot på opptil det største beløpet av 20 millioner euro og 4 % av selskapets totale omsetning på verdensbasis.

Høyrisiko AI-systemer vil blant annet omfatte følgende aktivitet:

Biometri og biometribaserte systemer.

Systemer som er sikkerhetskomponenter i aktivitet knyttet til kritisk infrastruktur, slik som forsyning av gass, vann, elektrisitet eller varme.

Systemer brukt for å evaluere og klassifisere nødanrop fra privatpersoner, som også anses som kritisk aktivitet.

Systemer i offentlig sektor brukt for å gjennomgå og håndtere sensitive saker, som asylsøknader og migrasjonsspørsmål.

Også bruk av AI-systemer hvor en bedrift for eksempel bruker AI til å gjennomgå jobbsøknader, og at systemet deretter rangerer kandidater basert på informasjon om dem, kan måtte anses som høyrisiko og med det innebære strenge plikter for bedriften. Et system som dette, som ved første øyekast kan anses problemfritt og befriende i en ansettelsesprosess, men som likevel kan utgjøre et høyrisikosystem som åpner opp døren for millionbøter, gir et bilde av problemstillinger som det vil være viktig å ta stilling til fremover. Heldigvis stilles det strenge krav til utviklere av programvare både når det gjelder dokumentasjon og testing av programvare før et program kan gjøres tilgjengelig på EU-markedet.

Begrenset

For systemer som faller inn i begrenset-kategorien, er det krav om åpenhet til AI-systemet. Slike åpenhets- eller transparenskrav vil innebære at brukerne av systemet skal gis informasjon om at systemet bruker AI og på hvilken måte.

For generativ AI, som ofte gjelder grunnmodeller utviklet for å genere bilder, lyd, tekst eller video, vil det gjelde særlige tilleggskrav, som informasjon om hva systemet har «trent på». Eksempelvis vil ChatGPT i større grad måtte gi brukerne informasjon om hva systemet har trent på og hvordan informasjonen som kommer ut, er generert, og for DALL-E, som er en tjeneste hvor man kan få et AI-system til å generere et kunstverk til deg basert på fritekst, og hvor systemet har trent seg på hundrevis av millioner av kunstverk og bilder som er tilgjengelig på internett, vil det sannsynligvis måtte gis informasjon om hvilke kunstverk som er benyttet som treningsgrunnlag og også om eventuelle rettigheter knyttet til disse.

Minimal eller ingen risiko

Systemer som ikke er innenfor kategorien uakseptabel risiko eller høyrisiko og som heller ikke er underlagt transparenskrav, betegnes som systemer med minimal eller ingen risiko. Dette kan være programmer som AI-drevne videospill eller spamfiltre og her stiller ikke AI-forordningen noen krav. Tilbydere av slike systemer oppfordres likevel til frivillig å følge etiske retningslinjer.

For revisjonsselskaper som bruker AI-systemer for gjennomgang av større datasett eller for å ekstrahere spesifikk informasjon fra datasett, eller liknende, er det nok ikke usannsynlig at systemet må klassifiseres i begrenset-kategorien, noe som kan innebære at revisjonsselskapet har åpenhetskrav å forholde seg til. Tilsvarende vil være tilfellet for advokatfirmaer som bruker AI-systemer til å gjennomgå kontrakter eller ekstrahere sammendrag fra større dokumentasjonsmapper. I tiden fremover vil også disse systemene bli viktigere i den daglige driften, noe som vil kreve at man holder tritt med utviklingen av både AI-systemer og reguleringen av AI.

Innovasjonsfremming, sanksjonsmyndighet og veien videre

Som nevnt innledningsvis har det vært knyttet usikkerhet til hvordan AI-forordningen vil påvirke innovasjon og utvikling av AI-systemer i EU. I den siste versjonen av AI-forordningen har det også blitt mer fokusert på dette, og det foreslås flere tiltak som er ment å skulle fremme slik utvikling.

Åpen kildekode – ingen krav

Det foreslås for det første at det ikke skal pålegges krav for AI-systemer og komponenter som utvikles med såkalt åpen kildekode, også kjent som «open source»-lisenser. På denne måten gis insentiv til åpen utvikling som også andre utviklere kan benytte seg av. EU-parlamentet har tidligere uttrykt at programvare med åpen kildekode kan bidra med 65–95 milliarder euro på det europeiske markedet og med det kan bidra til betydelige vekstmuligheter.

Regulatoriske sandkasser

For det andre foreslås innført såkalte «regulatory sandboxes», eller regulatoriske sandkasser, som skal være miljøer initiert av offentlige myndigheter, og hvor utviklere av AI kan få hjelp til utvikling og testing av AI-systemer, og hvor det også gis veiledning om forpliktelser og regelverk. De regulatoriske sandkassene er foreslått prioritert for mindre og mellomstore selskaper, og hensikten er i stor grad å fjerne noen av barrierene som disse selskapene ellers vil møte i utviklings- og lanseringsfasen.

Oppretter et uavhengig organ

I tillegg er det nå foreslått opprettelse av et AI-kontor, som skal være et uavhengig organ innad i Unionen. AI-kontoret skal gi råd, hjelpe og samarbeide med de forskjellige medlemslandene, blant annet på spørsmål om innføringen av AI-forordningen rundt om i Europa. I tillegg skal AI-kontoret ha et overordnet ansvar for å overvåke at AI-forordningen håndheves likt i de forskjellige medlemslandene. Kontoret skal også ha anledning til å mekle ved uenigheter, samt iverksette undersøkelser på eget initiativ. Det er videre foreslått at medlemslandene som innfører AI-forordningen, skal utpeke en nasjonal tilsynsmyndighet som skal føre tilsyn med implementering og bruk av AI-forordningen. Vi antar at en slik tilsynsmyndighet vil samarbeide med et AI-kontor også i Norge.

Nasjonal håndhevingsmyndighet

Foreløpig versjon av AI-forordningen inneholder også en rett for brukere og privatpersoner til å kunne sende inn klage til nasjonal håndhevingsmyndighet i tilfeller der man tror eller er usikker på om en tjeneste eller bedrift bryter med reglene i AI-forordningen.

Når utvikleren befinner seg utenfor EU

Et praktisk viktig punkt knyttet til håndheving av AI-forordningen, gjelder dens betydning for AI som rettes mot eller som kan benyttes innad i EU, men hvor utvikleren eller selskapet befinner seg utenfor EU. Det er spesielt viktig at det er håndhevingsmetoder overfor land som er langt fremme i AI-utviklingen, slik som for eksempel USA og Kina. Dersom AI-forordningen ikke kan håndheves overfor disse, faller mye av poenget med regelverket bort. For AI-systemer som er utviklet i, eller hvor utviklerne er basert i, tredjeland, skal AI-forordningen gjelde tilsvarende. De praktiske håndhevingsspørsmålene knyttet til dette er et eget tema og vil ikke problematiseres ytterligere. Oppsummert vil imidlertid den praktiske betydningen av dette være at alle utviklere av AI, uavhengig av hvor de befinner seg, og forutsatt at deres tjenester er tilgjengelige for brukere av AI innad i Europa, må forholde seg til AI-forordningen og kan risikere strenge og dyre sanksjoner dersom de bryter med AI-forordningens forpliktelser.

Ikke vedtatt i sin endelige form

Avslutningsvis understrekes at AI-forordningen ennå ikke er vedtatt i sin endelige form, og at det vil komme endringer til det foreløpige utkastet. Oppbygningen og mye av det konkrete innholdet vil imidlertid bestå, og det er ikke tvil om at AI-forordningen vil ha stor praktisk betydning for utviklingen av AI i årene som kommer. For revisjons- og regnskapsbransjen må det antas at ny teknologi i stor grad vil bli viktig i det daglige arbeidet fremover, og det kan forventes at måten man arbeider på, og muligens også hele bedriftsmodellen, vil se annerledes ut om fem eller ti år. Heldigvis er menneskelig tilsyn fortsatt helt nødvendig for å sikre at ting gjøres på riktig måte – i hvert fall enn så lenge.

Lovgiverarbeidet og foreløpig status

Siden forslaget til AI-forordningen ble fremmet i april 2021, har dets innhold, foruten diskusjon i offentligheten, vært gjenstand for omfattende debatt innad i EU-hierarkiet og dets komiteer og kommisjoner. Mye av det opprinnelige innholdet har også blitt revidert underveis, noe har ført til at det opprinnelige håpet om at AI-forordningen ville innføres i løpet av 2022, ikke gikk i oppfyllelse. Hva kunstig intelligens i det hele tatt skal defineres som, har det vært brukt mye tid på. I 2023 har imidlertid lovgivningsprosessen pågått for fullt, og 14. juni i år stemte Europaparlamentet med overveldende flertall for å gå videre med AI-forordningen. Lovgivningsprosessen fortsetter dermed inn i sluttforhandlinger (såkalte trilogforhandlinger), hvor målet er at Europakommisjonen, Rådet og Europaparlamentet skal komme til enighet om et omforent lovutkast.

Det er ventet at en slik enighet kan foreligge i løpet av 2023, noe som kan innebære at den endelige versjonen av AI-forordningen trer i kraft fra 2024. Videre er det ventet at AI-forordningen vil innføres med en toårs implementeringsperiode, noe som i praksis innebærer at regelverket vil gjelde fra og håndheves først to år etter ikrafttreden.

Det ovennevnte gjelder AI-forordningens antatte ikrafttredelse for EU-medlemslandene. Det antas også at AI-forordningen vil anses å være EØS-relevant når den endelige versjonen vedtas for EU, noe som betyr at AI-forordningen også blir gjeldende for Norge, om ikke med én gang. Ettersom det her er tale om en forordning, vil i så fall AI-forordningen inntas i norsk rett med likt innhold som for resten av EU-medlemslandene. Akkurat i hvilken form, og når regelverket vil innføres for norsk rett, er på dette tidspunktet ikke mulig å besvare, men det kan forventes at det for norsk rett også vil gjelde et tilnærmet likt regelverk på det tidspunktet hvor AI-forordningen håndheves i EU.